数据科学家大调查:职业受挫数据多样性,吐槽Hadoop

经过无数权威媒体的反复轰炸,我们大致已经相信,数据科学家是21世纪最神秘最性感最多金的职业,他们是大数据时代数据炸弹的拆弹专家,企业数字化经营的发动机,他们的身价堪比NFL四分卫,而且,他们比昆仑山上的雪豹数量还少。

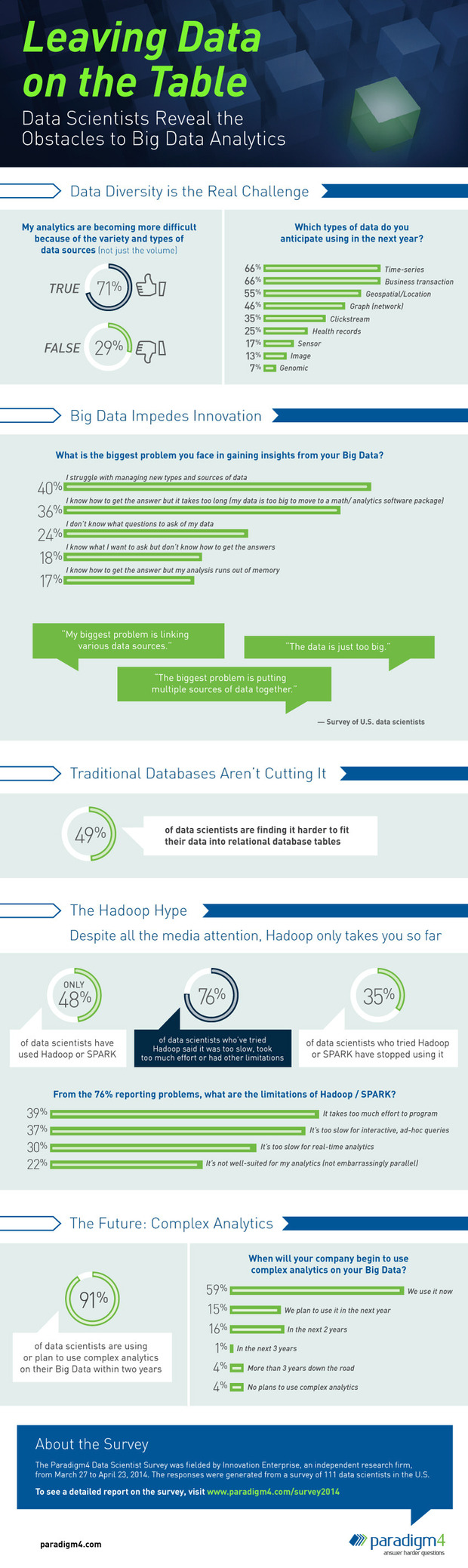

显然,数据科学家个个都是十八般数据分析武艺样样精通的绝世高手,但他们近来也有烦心事。不久前,开源数据库SciDB开发商Paradigm4进行的一项针对111名北美数据科学家的调查显示,71%的数据科学家认为数据来源的多样性(IT经理网记者此前曾与百度创始七剑客之一,酷我音乐CEO雷鸣讨论机器学习和大数据分析的最大挑战,他也认为是数据维度),而不是数据总量构成其职业最大威胁和挑战。

值得注意的是,只有48%的受访数据科学家表示他们在工作中曾使用过Hadoop或者Spark,高达76%的数据科学家抱怨Hadoop太慢,编程速度过慢,以及其他一些局限性。(参考阅读:Hadoop真特么难用)

虽然Hadoop口碑不佳,但是有接近半数的数据科学家表示很难将数据存入传统关系数据库表中。Nexedi的首席执行官Jean-Paul Smets在接受IT经理网采访时也曾指出,大数据的真正难题其实并不是所谓的“大”,业界目前缺乏是通过使用高效的分布式运算法则来处理数据的软件,Hadoop过于依赖Java,而Java已经被Oracle牢牢控制。中国兴起的去IOE运动,实际上为Hadoop之外的大数据软件方案提供了良机。

企业大数据进入复杂分析阶段

根据报告,有59%的数据科学家表示其所在企业已经开始采用更加复杂的分析技术,例如集群、机器学习、种量分析(Principal components analysis)、图论分析等高级分析技术分析数据,而不是局限于传统的BI报告。

还有15%的数据科学家表示计划在明年启用复杂分析技术,另有16%的数据科学家表示将在未来两年内采用复杂分析技术。

Hadoop被过度吹捧

Paradigm4的报告指出,Hadoop被过度吹捧成无所不能的,革命性的大数据解决方案,实际上Hadoop并不适用于需要进行复杂分析的大数据应用场景。

Hadoop的核心技术方法数据并行(data parallel),被Paradigm4称作“闹心的并行”。报告指出,复杂分析人物往往需要经常访问、处理和分享全体数据,并在数据处理中交叉沟通中间结果,而这恰恰是Hadoop MapReduce的软肋。

22%的受调查数据科学家表示Hadoop和Spark压根不适合他们的分析任务,此外还有35%的数据科学家在尝试Hadoop或Spark后停止使用这两项技术。

总结:

在快数据和机器学习为主要趋势的大数据潮流中,Hadoop作为开源系统,企业用户自主安装后,其性能优化有相当技术门槛。其实Hadoop系统也并非数据科学家反映得那样不堪用,Hadoop系统其实也可以快起来,例如老牌超算厂商Cray的Hadoop解决方案进行了软硬件调优,并且提供后继的技术支持,测试性能要高出很多倍,很好地解决了Hadoop性能差的问题。

Paradigm4数据科学家调查报告中的一些亮点被浓缩在下面这张信息图中,供有兴趣的读者深究:

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: