火爆全网的人工智能绘画工具抓取私人病例照片

数周以来,没有什么比人工智能图像合成(AI绘画)更火爆的大众AI应用了。谷歌Imagen和Stable Diffusion等人工智能绘画程序已经成了数字艺术家为之痴迷的工具。这些人工智能绘画程序通常使用一些流行的开源图片大数据集,例如LAION-B,对人工智能图像合成算法进行训练。

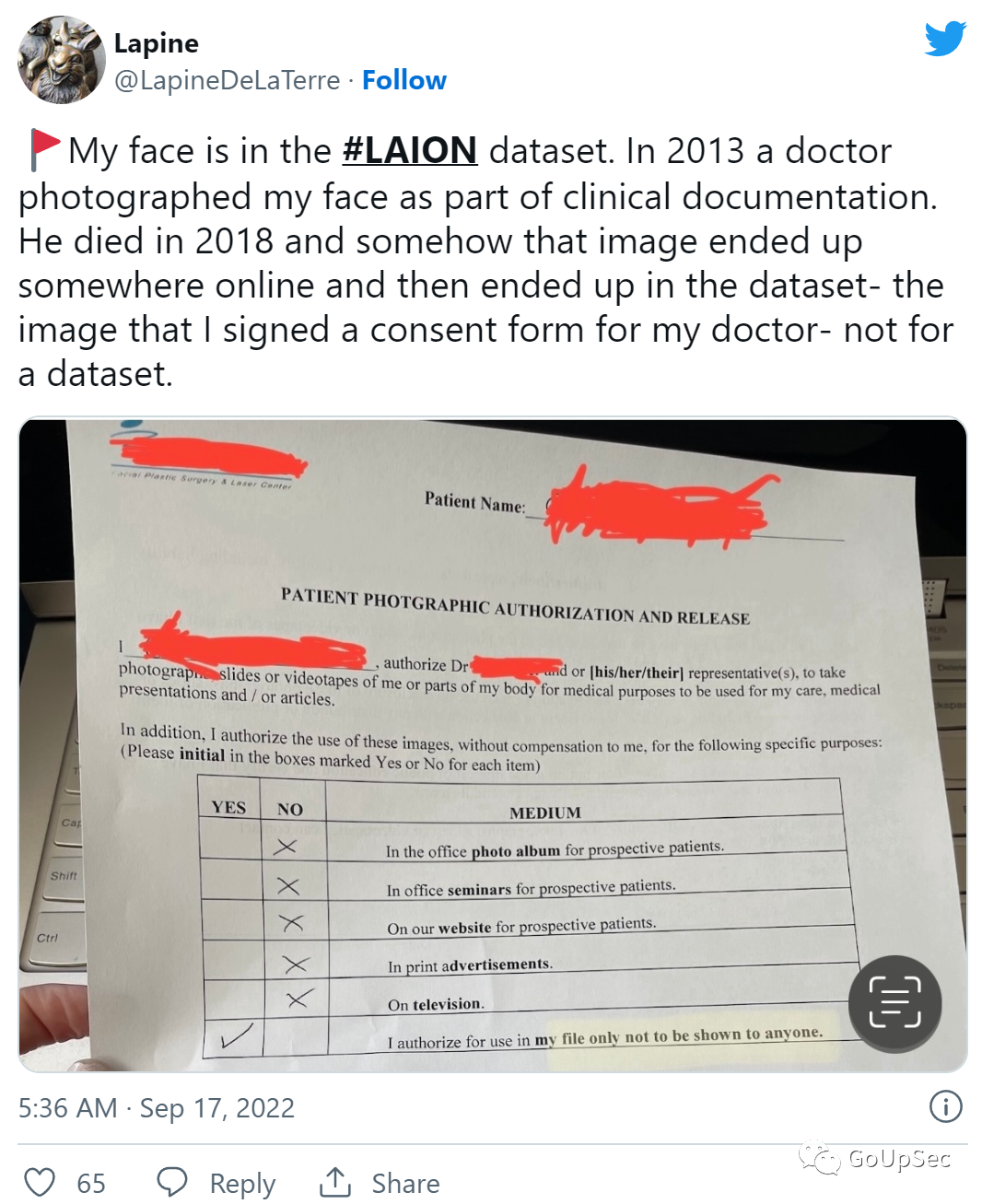

近日,一位名为Lapine的艺术家通过一个Have I Being Trained的网站反向查询LAION-B图片库,惊讶地发现自己的面部病例照片居然出现在训练数据集中,Lapine在推特上晒出了这些医学照片的使用协议,表明这些照片仅供医生使用,不得公开泄露:

显然,在拥有Lapine病例照片的外科医生去世后,这些照片不知何故从诊所泄露,被搜罗到了人工智能图像合成算法训练数据库中,并被“烘培”到无数人工智能合成的图像中。

科技媒体Ars确认了LAION数据集中确实存在Lapine的病例照片,而且在搜索Lapine的照片时,该媒体还在数据集中发现了数千张类似的患者病历照片,每张照片都可能存在类似的伦理或法律问题。GoUpSec的编辑则在这些训练数据库中发现了大量标有商业图片库水印的网络图片,其中许多可能已集成到当前流行的图像合成模型Midjourney和Stability AI中,并作为商业服务向企业提供。

LAION自称是一个拥有全球成员的非营利组织,“旨在向公众提供大规模的机器学习模型、数据集和相关代码。”其图像库数据可用于各种项目,从面部识别到计算机视觉再到图像合成。LAION宣传其开放方法比OpenAI等不公开数据源列表的封闭模型更合乎道德,例如麻省理工科技评论近日曾发文曝光GPT-3语言模型的输出文本中发现了机密数据。

例如,经过AI训练过程,LAION数据集中的一些图像被用来训练人工智能图像合成模型Stable Diffusion的流行功能——“从文本描述生成图像”。由于LAION是一组指向互联网上图像的URL集合,因此LAION本身并不托管图像。相反,LAION表示,当研究人员想要在项目中使用这些图像时,他们必须从不同的位置下载这些图像。

LAION数据集充满了从互联网收集的潜在敏感图像,如上图所示,现在正集成到商业机器学习产品中。

Lapine的一位朋友在LAION的Discord服务器频道#safety-and-privacy询问如何从场景中删除私人图像。LAION工程师Romain Beaumont回答说:“从互联网上删除图像的最佳方法是要求托管网站停止托管它,LAION没有托管任何这些图像。”

显然,LAION在利用“元数据”来钻法律空子推卸责任,因为在美国,从互联网上抓取(索引)公开数据似乎是合法的。不过LAION的网站确实提供了一个表格,欧洲公民可以请求从其数据库中删除信息以遵守欧盟的GDPR法律,但前提是个人照片与图像元数据中的姓名相关联。幸亏有了PimEyes这样的服务,隐私遭到侵犯的个人将人脸照片与本人姓名关联变得非常容易。

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: