美国防部发布人工智能工具可识别人工智能造假视频

解铃还须系铃人,人工智能技术制作的假视频也可以通过人工智能发现 – 但这可能只是AI军备竞赛的开始

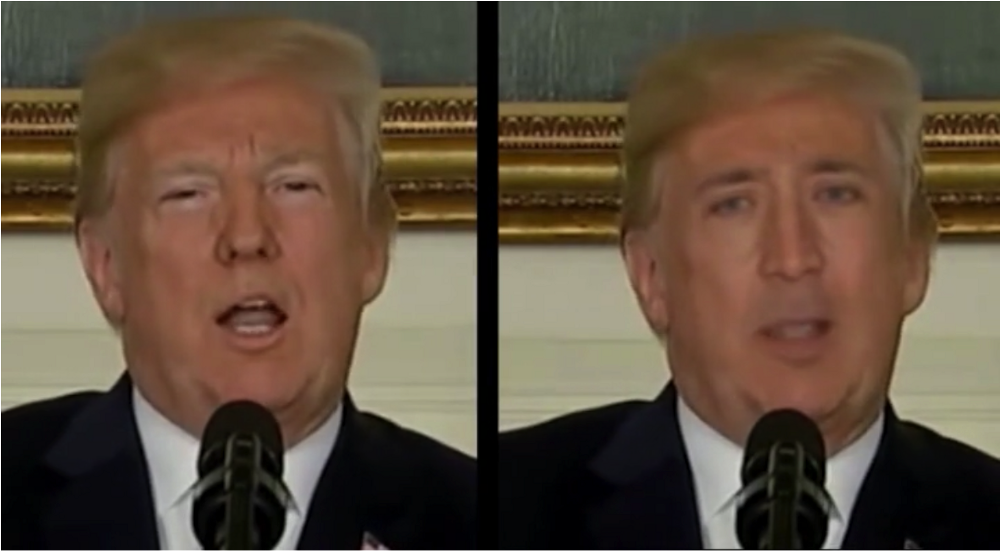

被尼古拉斯凯奇“客串”的特朗普演讲视频 Photo: SUNY

美国国防部高级研究计划局DARPA最近发布了一个人工智能检测取证工具——Media Forensics,利用AI人工智能技术来识别报复性色情造假视频(换头)和假新闻视频。

面对日益猖獗的,足可以假乱真的人工智能合成的假视频和假新闻图片,司法专家迫切需要一种高效准确的检测方法或工具。

如今利用PS换头之类的图片已经过时,最“时髦”的玩法是用人工智能的机器学习技术合成“深度伪装”(deepfake)视频,正如本文开头的特朗普演讲视频被换成了尼古拉斯凯奇的头像。这种人工智能合成的视频不但制作门槛很低,而且看起来足够逼真。由于人们对视频的信任度依然很高,因此视频造假和类似假新闻的传播对社会的危害巨大。

人工合成假视频需要用到一种机器学习技术——生成建模(Generative modeling),该技术的原理简单来说就是让计算机实现“学习”大量真实数据,然后生成统计学上极为相似的虚假样本。最近这项技术进一步演化,使用两个神经网络,称为生成对抗网络(generative adversarial networks),共同产生足可乱真的虚假样本(参见“ GAN之父:给机器赋予想象力的人 ”)。

DARPA开发的Media Forensics媒体调查取证工具可以有效地识别那些被GAN篡改过的视频,例如下图下面这组被偷换成尼古拉斯凯奇的主持人视频截图:

图片来源:纽约州立大学奥尔巴尼分校

纽约州立大学奥尔巴尼分校教授斯Siwei Lyu领导的团队开发了一个非常简单的技术。“我们制作了大约50个假视频,并用传统的取证检测方法。时灵时不灵,效果不是很好“吕说。

然后,一天下午,在研究几个深刻伪造视频时,Lyu无意中发现:使用人工智能技术伪造的面孔很少眨眼。而且当它们眨眼时,眼球运动也是不自然的。这是因为机器学习技术基于“睁着眼”的静态图像数据训练的结果。

参与DARPA挑战赛的其他研究者也在探索类似的方法,以自动捕捉人工智能造假特征,例如奇怪的头部动作,奇怪的眼睛颜色等等。达特茅斯学院数字取证专家Hany Farid说:“我们正在深入研究特定类型的生理信号,至少目前这些信号很难被机器模仿。”

DARPA的Turek表示,该机构将举办更多竞赛,“以确保开发中的技术能够检测到最新的人工智能造假技术。”

能够对抗人工智能造假的取证工具的到来,可能仅仅是视频伪造者和数字侦探之间人工智能军备竞赛的开始。Farid说,一个严峻的挑战是,机器学习系统也可以接受训练后“欺骗”取证工具。(参考阅读:AI 对抗样本在机器视觉领域的安全攻击与防御)

Lyu说,熟练的伪造者可以通过在训练数据中增加一个人眨眼的图像数据来绕过检测工具。但他补充说,他的团队已经开发出一种更有效的技术,目前依然处于保密阶段。“我们现在比伪造者有一点优势,我们希望保持这种优势。”Lyu说道。

本文来自:MIT Technology Review IT经理网编译整理

第一时间获取面向IT决策者的独家深度资讯,敬请关注IT经理网微信号:ctociocom

除非注明,本站文章均为原创或编译,未经许可严禁转载。

相关文章: